Алгоритмы в нашей жизни: как Big Data управляет нами

Алгоритмы захватили мир. Сегодня именно они решают, когда к вам приедет Uber, выдадут ли вам кредит в банке, будет ли заключенный досрочно освобожден и кого нужно обыскать при проверке багажа. В Соединенных Штатах специальная программа решает, в какой район отправить патруль и даже с точностью предсказывает где и когда будет совершенно преступление. Как с этим дальше жить, рассуждает журналист CJR Хава Гурари (Chava Gourarie @ChavaRisa).

Мы как заядлые пользователи привыкаем к гигантам сети: невидимые щупальца Google, Facebook и Amazon регулярно поставляют кормежку к нашим мониторам. Мы окружены проприетарными кодами от мемов в Twitter, автозаполнения в Google, рекомендаций от Netflix и совпадений OKCupid. Настоящее интернет-месиво. Недавно Instagram объявил об изменении в алгоритме ленты и интернет взорвался возмущением (Дуров, верни стену!). Когда гиганты Силиконовой долины начинают вторгаться в сферы, которые мы считаем личной жизнью, мы начинаем осознавать, кому все-таки принадлежит вся власть. И это раздражает.

И если некоторые интернет-пользователи смирились с подобным алгоритмическим доминированием, то журналисты не могут себе этого позволить. Алгоритмы заставляют журналистов снова и снова делать один и тот же вывод: «Они могущественные, засекреченные правители всех важных сфер общества». И задача журналиста вывести код на чистую воду.

Сделайте эти 5 шагов, и о вас точно напишут в СМИ. Скачать!«Алгоритмы, словно, малые дети. На них влияет среда обитания».

Алгоритмы призваны приблизить действительность к образу, который позволил бы достичь цели их разработчика, и «выстраивают ряд предположений о том, как устроен мир и как он должен работать», – говорит Марк Хансен, статист и руководитель института им. Брауна при Колумбийском университете.

И задача журналиста состоит в исследовании этих предположений и их последствий, особенно если они касаются политики. Первый шаг заключается в применении классических журналистских навыков в новой области: опрос представителей власти и привлечение экспертов из сфер, в которых мы не разбираемся. Несмотря на способность алгоритмов проводить вычисления, на которые человеческий мозг не способен, указанного подхода бывает недостаточно при их исследовании. При написании статей об алгоритмах журналистам следует расширить свои знания в области обработки данных. Это позволит им разобраться во все более усложняющихся алгоритмах, которые управляют нашими жизнями.

Ситуация на сегодня

Лишь немногие новостные отделы занимаются освещением алгоритмов. Но начало положено.

Алгоритмы можно разделить на 3 части: входные данные, сам алгоритм и то, что на выходе — прогноз, оценку. Журналисты освещают алгоритм на любой из трех указанных стадий – это анализ входных данных, оценка выходных данных, рассмотрение архитектуры алгоритма с целью выявления путей, по которым мы приходим к какому-либо суждению.

В настоящее время большинство сообщений подобного рода базируются на полученных результатах и направлены на перестройку алгоритмов с применением методов, аналогичных для журналистики данных. Издание Wall Street Journal использовало подобные методы и выявило, что цены в онлайн-магазине офисных товаров Staples определяются расстоянием между покупателем и магазинами конкурентов. Издание ProPublica, в свою очередь, провело анализ, который предполагает, что всплеск цен на онлайн-услугу вызова такси Uber увеличивает только ее стоимость, а не доходы водителей.

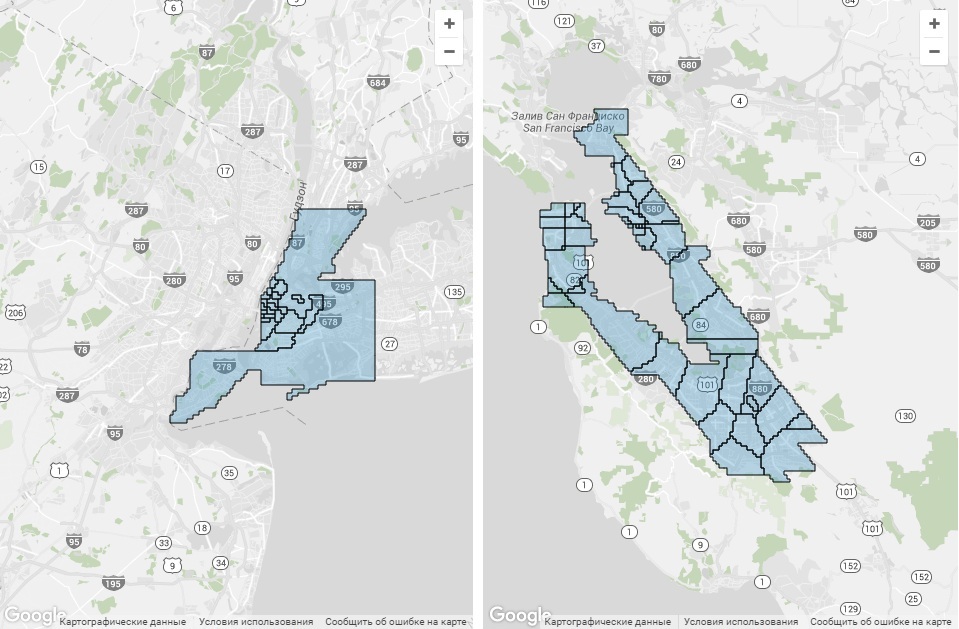

ProPublica использовали данные исследователей из Северо-восточного университета, чтобы создать эти карты охвата районов Uber для центральной части Манхэттена и в центре Сан-Франциско . Данные были собраны в апреле и мае 2015 года

Подобных исследований много. Например, в сфере уголовного правосудия было написано множество статей на тему патентованного алгоритма, который используется правоохранительными органами. Так программное обеспечение Beware помогает полиции г. Фресно, США, использовать записи в Twitter для определения «степени угрозы» того или иного жителя; одному калифорнийцу грозит срок за изнасилование почти 40-летней давности в связи с совпадениями в анализе ДНК, проведенном программой TrueAllele; и сегодня полицейские участки по всей Америке все чаще внедряют прогностическое программное обеспечение, например, PredPol, которое назначает районы для отправки патруля.

Газета New York Times сообщает о культуре банковских стартапов, использующих большой объем данных для определения порядка кредитования граждан. Целью некоторой части (довольно большой) является выявление групп населения, которые обычно игнорируются кредиторами. Исходя из этого, одна компания утверждает, что вместо кредитной истории программа определяет кредитоспособность по факторам: использует ли заявитель почтовую систему расчетов CAPS (Centralized Account Processing System), или сколько времени он тратит на прочтение условий предоставления кредита. Подобные сообщения оставляют больше вопросов, чем ответов. Является ли такой метод более справедливым?

В сущности, этот вопрос порождает еще больше рассуждений на тему алгоритмов.

Может ли алгоритм быть расистским?

«Алгоритмы, словно, малые дети», – говорит Суреш Венкатасубраманьян. «На них влияет среда обитания».

Г-н Венкатасубраманьян является профессором информатики в Университете штата Юта. Он один из тех, кто размышляет над справедливостью алгоритмов. «Что произойдет, если мы начнем жить в мире, который полностью подчиняется алгоритмам?» — спрашивает Венкатасубраманьян.

И он не единственный, кто задается данным вопросом. Подотчетность алгоритмов – это дисциплина, которая в настоящее время развивается в целом ряде областей. Специалисты в сфере информатики, правоведения, политики борются над выявлением или предотвращением фактов предвзятости в алгоритмах, над эффективным установлением стандартов подотчетности в области предпринимательства и государственного управления. Большая обеспокоенность высказывается в адрес наличия (и степени) предубеждений в алгоритмах против групп меньшинств.

Подотчетность алгоритмов базируется на существующем законодательстве и политике, которые направлены на борьбу с дискриминацией в области проживания, занятости, расы, ориентации и тд; данная подотчетность применяет понятие «неравного влияния», которое рассматривает влияние политического курса на защищаемые классы населения, а не его намерения. То есть алгоритмы не должны иметь расистские проявления во избежание дискриминации.

Алгоритмы призваны приблизить действительность к образу, который позволил бы достичь цели их разработчика.

Но алгоритмы особенно подвержены предвзятости по двум причинам:

Виртуальный пиарщик Pressfeed — подберет СМИ под вашу тему, напишет текст, организует выход публикации или интервью. Оплата за результат!- Алгоритмы могут кодировать человеческую предвзятость, преднамеренно или непреднамеренно. Это происходит в связи с использованием исторических данных или классификаторов, которые оказывают влияние на предубеждения (например, касательно геев). Это особенно актуально для алгоритмов машинного осмысления, которые обрабатывают вводимые пользователем данные. Например, исследователи Университета Карнеги-Меллона выявили, что в сети Google женщины получают объявления только о низкооплачиваемой работе, но они не были уверены, почему. По их мнению, это происходит потому, что женщины чаще переходят по ссылкам с такими объявлениями, алгоритм обрабатывает подобное поведение и выявляет закономерность.

- Алгоритмы имеют некоторые несправедливые тематические индексы цитирования (ТИЦ), многие из которых изложены в статье «Насколько Big Date несправедлив». Автор отмечает, что поскольку алгоритмы стремятся выявить закономерность, а меньшинство не совпадает с закономерностями, которые присущи большинству, результаты будут отличаться для членов меньшинства. И если общий показатель эффективности алгоритма высок, он может не учитывать людей, которые не принадлежат к данной группе.

Для исправления этого недостатка Венкатасубраманьян вместе с несколькими коллегами опубликовал работу о том, как специалисты в области программирования могут математически тестировать алгоритмы на предмет их предвзятости, эти методы могут быть использованы и при определении точности или погрешности в других проектах по обработке данных. Он также разработал инструмент для специалистов в других областях, основанный на статистических принципах, который оценивает загружаемые данные по «показателю справедливости». Хотя данный инструмент не способен проверить справедливость самого алгоритма, он, по крайней мере, может проверить это качество у вводимых вами данных. Венкатасубраманьян поясняет, что большинство алгоритмов базируются на поставляемых данных, так что это первостепенный пункт, который должен пройти проверку на предвзятость.

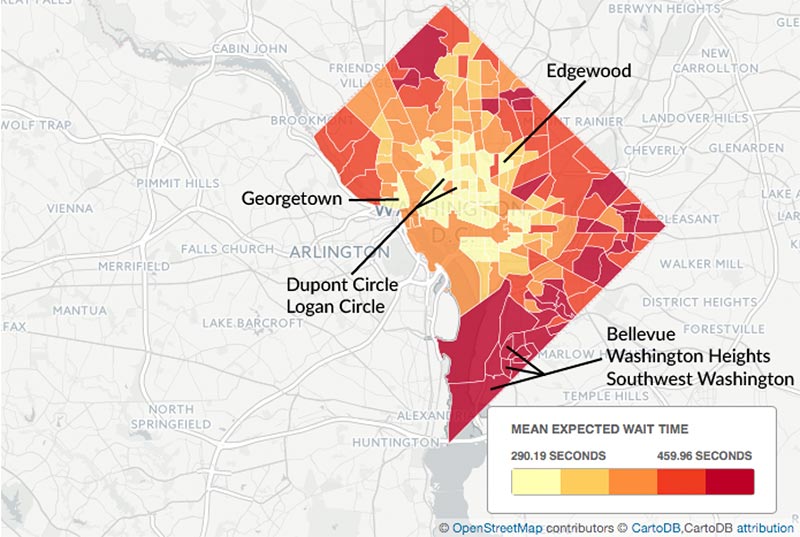

Предвзятость является одной из главных проблем и для работы прогностического ПО, используемого полицией, таком как PredPol. Данная программа помогает полицейским сосредотачивать ресурсы в определенном районе. Она выявляет закономерности на основании данных о прошлых преступлениях и позволяет прогнозировать районы вероятного совершения преступлений. По словам журналиста из Marshall Project Мориса Шамма, который исследует процесс прогнозирования в полицейских службах, главный вопрос – не приведет ли подобный метод к чрезмерному контролю над меньшинствами. «Есть опасения, что если исследовать только данные об арестах и закладывать их в основу алгоритма, – говорит он, – то алгоритм будет снова и снова отправлять вас в гетто».

Работа в обратном порядке

Как и любая другая зарождающаяся область, исследование алгоритмов сталкивается с некоторыми трудностями. Во-первых, у нас до сих пор отсутствует общее понимание последствий алгоритмов, и, следовательно, мы не знаем, на что или кого свалить вину. Если компьютеры могут быть расистами, кто несет ответственность за дискриминирующие входные данные?

Журналисты не обязаны давать ответ на этот вопрос, но они должны учесть это в анализе и заключениях.

В примерах о Princeton Review и Uber полученные выводы, по всей видимости, ничто иное, как результат капитализма. ProPublica называет выводы касаемо Princeton Review «неожиданными», подразумевая, что компания не применяет «азиатский» классификатор как фактор формирования ценового предложения. Что касается времени ожидания в Uber, то карта, прилагаемая к статье, может также оказаться тепловой картой спроса на услугу. Конечно, ценовая дискриминация – неприятное явление, но она абсолютно законна, если открыто не применяется в адрес защищаемых классов.

«Превосходный анализ», – Джонатан Стрей, журналист-преподаватель Школы журналистики в Колумбии, говорит о статье на тему Uber, – но я столкнулся с некоторыми трудностями при интерпретации результатов». По мнению Стрея, проблема в том, что расовую дискриминацию можно связать с любым другим фактором. Это происходит потому, что многие факторы такие, как местоположение и уровень доходов, выступают в качестве прокси-серверов для расы, и они порой неожиданным образом взаимодействуют друг с другом.

10 кейсов о росте трафика, продаж и продвижении бизнеса с помощью СМИ. Скачать!«Вам следует быть особо осторожными, когда вы называете подобные причины», – говорит Стрей. И даже если приложение Uber не причем, получается, что все-таки какая-то вина на нем есть. «Обязан ли Uber предоставлять услугу на одинаковых условиях?»

Следует ограничивать распространение данных, выводимых в результате алгоритма, принцип действия которого не известен.

Например, ProPublica провела проверку цен онлайн-подготовки к стандартизированному тесту для каждого почтового индекса в США, затем провела анализ полученных данных, чтобы выявить возможные факторы, которые влияют на разницу в ценах. Подобный подход отличается от обычных методов анализа, которые используются в бюро переписи населения США или при подсчете уровня безработицы. В их случае вы точно знаете, откуда получены данные и как они были собраны. Это позволяет вам задавать вопросы об их ценности и определять точные границы анализа. В случае с выходными результатами алгоритма в рамках даже самого сложного анализа максимум, что вы можете сделать – это определить, что что-то происходит, но не каким образом.

По мнению Джефа Ларсона, редактора данных ProPublica и автора статьи «Налог мамы-тигрицы», это необязательно плохо. Как и неравное влияние, важная информация считается таковой, если она описывает, как кто-то или какая-то группа людей подвергается негативному воздействию, независимо от мотива такого воздействия.

«Не во всех историях есть антагонист», – утверждает Ларсон. В хорошей истории не обязательно должен присутствовать злобный дядя, который «ехидно теребит бородку».

Внутри черного ящика

Конечно, работа с выходными данными – не единственно возможная стратегия. Вместо того чтобы просто смотреть на результаты алгоритмов и пытаться работать от обратного, журналистам следует устремить взгляд в сторону «черного ящика» (помните, что это и есть реальная архитектура алгоритма).

Доступ к коду или проекту алгоритма открывает совершенно новые горизонты. Это отчетливо видно из сообщения Marshall Project о полицейском программном обеспечении. В статье под заголовком «Патруль будущего» Шамма и Хансен описывают программу HunchLab, которая является аналогом более распространенной PredPol с одной лишь разницей: алгоритм более прозрачен. Компания-разработчик Azavea поделилась методами и моделями с репортерами Marshall Project.**

Большинство алгоритмов, используемые в сферах бизнеса и госуправления, являются собственностью учреждения, и не совсем понятно, какие исходники будут доступны по закону «О свободе информации». Несколько дел были переданы в суд на основании указанного или других законов с исками о передаче исходного кода или соответствующих документов, но большинство из них попадают под термин коммерческой тайны или связаны с обеспечением безопасности.

Например, Центр электронной частной информации (ЦЭЧИ), некоммерческая организация со штаб-квартирой в Вашингтоне, запросила документы о системе, которая производит оценку уровня опасности пассажирского воздушного и наземного транспорта США. Компания Analytic Framework of Intelligence собирает данные из обширных источников: правительственных и неправительственных баз данных, ресурсов Интернета – и затем производит оценку. После постановления федерального суда о раскрытии информации погранично-таможенная служба США, которая использует данную программу, отправила в адрес ЦЭЧИ несколько сильно отредактированных документов. Один документ содержал затемненные скриншоты приложения. Погранично-таможенная служба объяснила это тем, что «лицо, владеющее компьютерной техникой», может взломать программу, используя данные скриншоты. ЦЭЧИ снова обратился в суд с иском о получении полной информации.

То есть буквально вопрос с доступом решен, но требуется рассмотреть исходный код. Анализ исходника требует знаний алгоритма, что не является компетенцией журналиста, он также требует сотрудничества со специалистами в области вычислительной техники и других наук.

По словам Хансена, программисты «закладывают в код ценности и этические нормы нашего общества», и поэтому данный процесс должен быть открытым для посильного участия общественности.

Какую бы форму ни приобрели сообщения на тему алгоритмов, они требуют все больше знаний и навыков. Журналистам следует играть по правилам – соблюдать прозрачность алгоритмов и приумножать набор навыков для более эффективной работы в век интеллектуального прогресса.

Комментарии